Trends im Datenmanagement für die kommenden Jahre

Alle reden von Daten und datengesteuerten Organisationen. Zweifellos werden datenbezogene Themen die Technologietrends der nächsten Jahre dominieren. Aus diesem Grund haben wir die 5 spannendsten Themen zusammengestellt, die Sie im Auge behalten sollten.

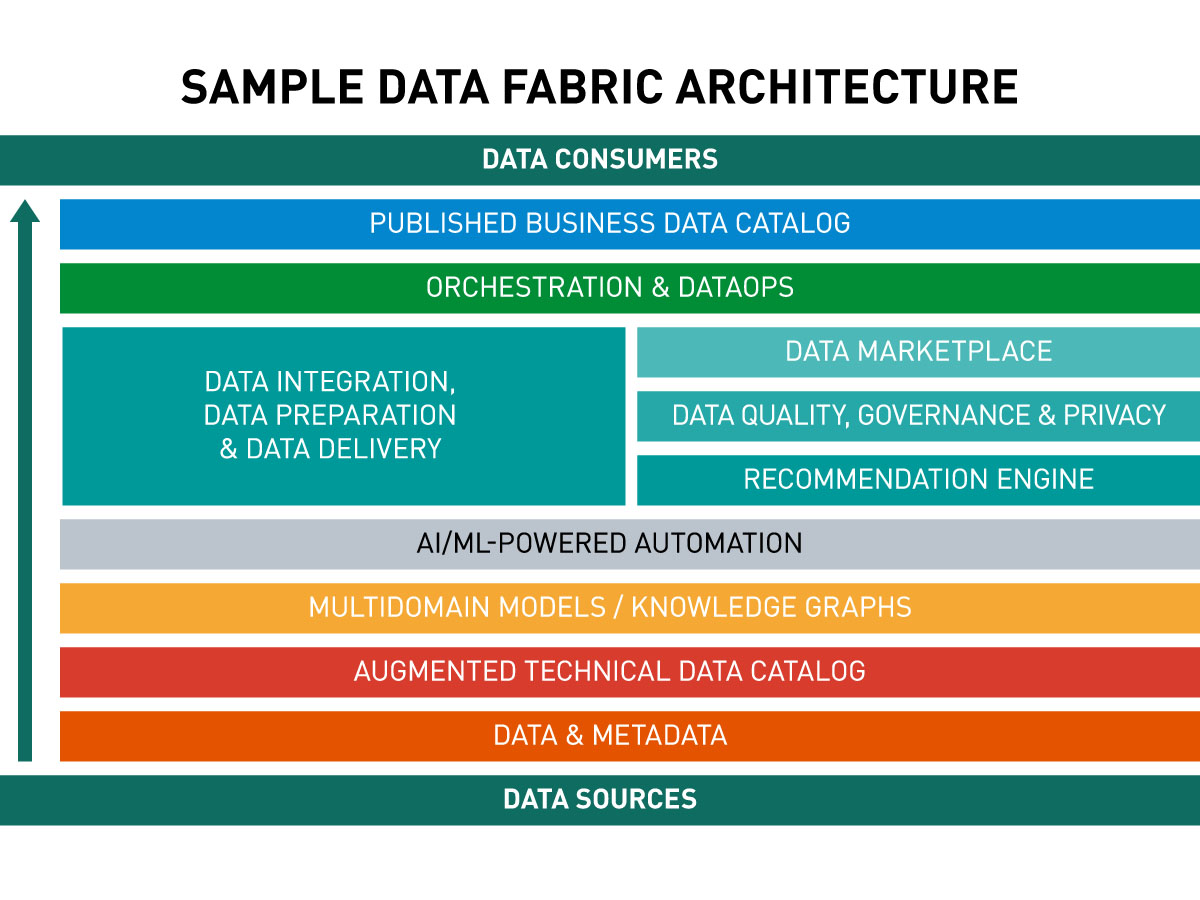

Data Fabric

Data Fabric ist ein innovatives Konzept für die Verwaltung riesiger Datenmengen, die auf zahlreiche unverbundene Quellen in On-Premise-, Multi-Cloud- und Hybrid-Umgebungen verteilt sind.

Eines der Hauptziele von Data Fabric ist die Maximierung des Business Values von Informationen durch die Demokratisierung von Daten. Mit Data Fabric erhalten Datenkonsumenten im gesamten Unternehmen, einschließlich Geschäftsanalysten, einfachen Zugriff auf vertrauenswürdige Daten aus allen Quellen – und zwar genau dann, wenn sie sie benötigen.

So müssen sie nicht mehr recherchieren, wo die von ihnen benötigten Informationen gespeichert sind, wem sie gehören, welche Qualität sie haben oder in welchem Format sie verfügbar sind. Sie können umgehend Analysen durchführen, eine Geschäftsidee validieren oder andere Aktivitäten durchführen, ohne lange darauf warten zu müssen, dass die relevanten Daten gesammelt, konsolidiert und ordnungsgemäß aufbereitet werden.

Data Fabric ist weder eine Technologie noch ein einzelnes Produkt. Es handelt sich um eine Kombination aus einem bestimmten Konzept der Datenarchitektur und einer Reihe von Tools, die zur Umsetzung dieses Konzepts erforderlich sind. Außerdem gibt es kein einziges universelles Architekturmuster für Data Fabric. Verschiedene Softwareanbieter haben ihre eigene Sichtweise auf dieses Konzept, die in erster Linie auf die von ihnen angebotenen Lösungen zugeschnitten ist.

Ein wichtiges Merkmal dieser Architektur ist die Modularität, die sie äußerst flexibel macht. Bei der Zusammenstellung einer Datenplattform zur Unterstützung von Data Fabric kann ein Unternehmen beliebige Funktionen einbeziehen, darunter Data Governance und Datenschutz, Compliance, Datensicherheit, Datenanalyse, Datenintegration, Datenqualität, Datentransformation, Datenanreicherung, Datenaufbereitung oder was immer es sonst benötigt.

Ein weiterer großer Vorteil dieses Ansatzes ist die Möglichkeit, sowohl die bestehende Dateninfrastruktur als auch neue Tools und Technologien nutzen zu können.

Data Fabric ermöglicht somit die evolutionäre Modernisierung der Datenumgebung eines Unternehmens durch das schrittweise Ersetzen von Altsoftware durch neuere oder umfassendere Lösungen.

Die Grundannahme von Data Fabric besteht darin, die Daten in ihrer ursprünglichen Quelle zu belassen, wo ihre Konsistenz und hohe Qualität gewährleistet sind.

Ermöglicht wird dies durch Datenvirtualisierung. Anstatt ein weiteres zentrales Repository zu erstellen und Daten dorthin zu replizieren oder zu verschieben, wird ein Datenkatalog verwendet, der alle Quellen nach Metadaten durchsucht. Dadurch wird ein virtueller Index aller Datenbestände aus allen vorhandenen Quellen im Unternehmen erstellt, unabhängig von Standort, Typ, Format oder Technologie.

Mit einem solchen Katalog erhalten die Benutzer einen vollständigen Einblick in die Datenbestände eines Unternehmens, beispielsweise in das Spektrum der Kundendaten, die in verschiedenen Quellen verfügbar sind. Die Benutzer können Daten nach verschiedenen Kriterien suchen, filtern und sortieren, darunter auch nach Datenqualitätsmetriken. Auf diese Weise können sie beispielsweise sehen, welche Quelle die aktuellsten und zuverlässigsten Kunden-E-Mails bietet.

Jede einzelne Aktion wird selbstverständlich unter Berücksichtigung von Data Governance, Datenschutz und Sicherheit durchgeführt.

Der Zugriff auf die Daten erfolgt über den Data Marketplace. Hier können Benutzer nicht nur die verfügbaren Datenbestände durchsuchen, sondern auch einen bestimmten Datensatz bestellen, beispielsweise für eine Marketing- oder Vertriebskampagne.

Der Name erinnert nicht zufällig an einen Online-Shop. Data Marketplaces funktionieren ganz ähnlich. Ein Datenkonsument durchsucht die verfügbaren Ressourcen, legt die benötigten Datensätze in den Warenkorb und gibt dann eine Bestellung auf, um das zusammengeführte Datenpaket im gewünschten Format, z. B. als Excel-Tabelle, geliefert zu bekommen.

Data Fabric wird oft als Lösung zum Aufbrechen von Datensilos bezeichnet. Aber was bedeutet das in der Praxis?

„Die ursprünglichen Datenbestände werden durch Data Fabric weder verändert noch ersetzt” – erklärt Krzysztof Wiśniewski, Senior System Architect bei Striped Giraffe. „Data Fabric kann als eine Art Gewebe betrachtet werden, das über alle vorhandenen Datenquellen gelegt wird, sie miteinander verbindet und ihre Funktion als eine einzige virtuelle Umgebung ermöglicht. Aus der Sicht des Datenkonsumenten verschwinden so die Datensilos. Es gibt nur noch einen zentralen, metadatengesteuerten Katalog aller Daten, der über den Data Marketplace durchsucht und abgefragt werden kann. Man könnte sagen, dass Data-Fabric die Probleme löst, die durch Datensilos verursacht werden, ohne die Silos selbst physisch zu beseitigen.”

In den Services, die die Data-Fabric-Architektur bilden, können die meisten Prozesse automatisiert werden. Dadurch wird die Effizienz erheblich gesteigert und in vielen Fällen können Benutzer, Systeme und Anwendungen in Echtzeit auf die benötigten Daten zugreifen.

Gartner schätzt, dass Data Fabric verschiedene Datenmanagement-Aufgaben, einschließlich Design, Bereitstellung und Betrieb um 70 % reduzieren kann.

Viele Datenexperten weisen darauf hin, dass Data Fabric die Zukunft des Datenmanagements ist. Laut Gartner werden Data-Fabric-Implementierungen bis 2024 die Effizienz der Datennutzung vervierfachen und gleichzeitig die manuellen Datenverwaltungsaufgaben um die Hälfte reduzieren.

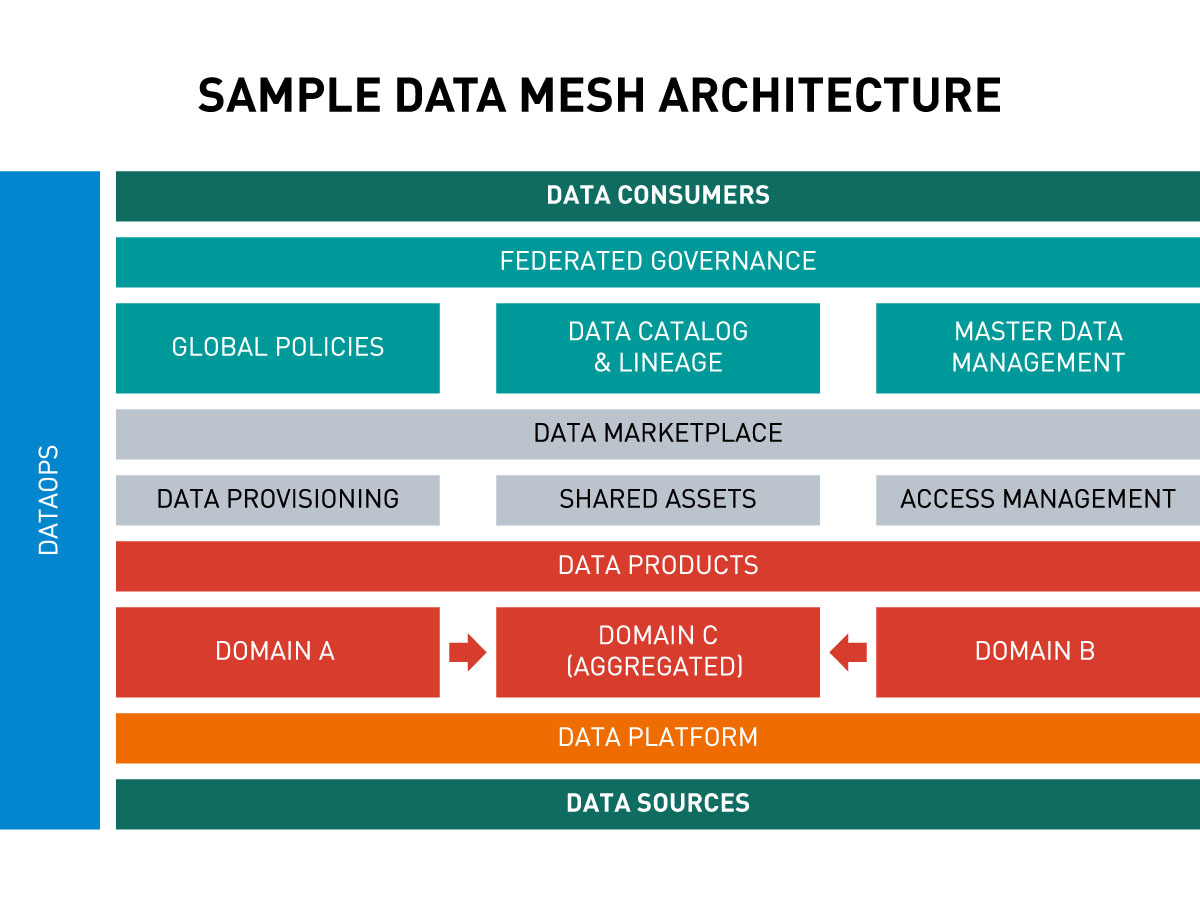

Data Mesh

Data Mesh ist ein weiteres neues Konzept für den Aufbau einer Datenarchitektur in einer Umgebung mit heterogenen Datenquellen.

Auf den ersten Blick sehen Data Fabric und Data Mesh recht ähnlich aus. Der grundlegende Unterschied besteht darin, dass Data Mesh einen dezentralen und bereichsorientierten Ansatz für die Datenarchitektur darstellt. Im Gegensatz dazu verwaltet Data Fabric mehrere Datenquellen wie ein einziges virtuelles und zentralisiertes Datensystem, in dem Datendomänen kaum eine Rolle spielen.

Anstatt beispielsweise Marketing-, Vertriebs-, Finanz-, Personal- und Logistikdaten in einer einzigen Domäne zusammenzufassen, wird in einer Data Mesh-Architektur jeder dieser Datensätze in eine andere Domäne getrennt.

Data Mesh beruht auf den folgenden vier Grundprinzipien:

1. Hoheit über die Domäne

Im Gegensatz zu Data Fabric gibt es kein zentrales Team, das für die Verwaltung aller Daten und deren Bereitstellung für die Datenkonsumenten auf dem Data Marketplace verantwortlich ist. Das Eigentum an Analyse- und Betriebsdaten wird an Domänen-Teams übertragen.

Die Domänen-Teams sind für den gesamten Lebenszyklus der Datenprodukte innerhalb ihrer Domäne verantwortlich. So ist beispielsweise ein Team nur für den Bereich der Finanzdaten zuständig, ein anderes für die Personaldaten und ein weiteres für die CRM-Daten.

Das Bereichsteam führt selbst die Analysen durch, die für datengestützte Entscheidungen erforderlich sind. Bei Bedarf kann es sich die benötigten Informationen aus anderen Bereichen beschaffen.

2. Daten als Produkt

In einem Data Mesh werden Daten wie ein Produkt behandelt, das seine Abnehmer hat. Es wird davon ausgegangen, dass es außerhalb einer bestimmten Domäne irgendwo in der Organisationsstruktur, Teams gibt (bei denen es sich um andere Domänen-Teams handeln kann), die Verbraucher dieser Daten sind und sie für Analysen benötigen.

Daher besteht die Hauptverantwortung des Domänen-Teams darin, geeignete Datenprodukte zu erstellen, die den Anforderungen der Datenkonsumenten außerhalb des Teams entsprechen. Das Domänen-Team muss sicherstellen, dass seine Daten von hoher Qualität und für andere zugänglich sind.

Bei einem Datenprodukt handelt es sich in der Regel um einen bereichsspezifischen Datensatz, der durch Metadaten beschrieben wird, die das Auffinden, den Zugang und die Nutzung der Daten erleichtern. Zu diesen Metadaten gehören Eigentums- und Kontaktinformationen, Datenstandort und -zugang, Aktualisierungsfrequenz und Datenmodellspezifikation.

Auf dem Data Marketplace können Datenkonsumenten Datenprodukte direkt in dem Bereich, der sie interessiert, durchsuchen und die erforderlichen Daten bestellen, die vom zuständigen Domänen-Team für sie aufbereitet werden.

3. Selbstverwaltete Datenplattform

Wie bei Data Fabric ist ein fester Bestandteil des Data Mesh-Konzepts eine Self-Service-Datenplattform. Sie bietet alle erforderlichen Funktionen, einschließlich Speicherung, Datenabruf, Verarbeitung, Analyse, Visualisierung, Metadaten- und Berechtigungsverwaltung usw.

Die Datenplattform stellt den Domänen-Teams die notwendigen Werkzeuge zur Verfügung, um:

- die Qualität ihrer Daten zu gewährleisten

- auf einfache Weise eigene Datenprodukte zu erstellen und sie den Datenkonsumenten zur Verfügung zu stellen

- Datenauswertungen durchzuführen

- Datenvisualisierungen zu erstellen

- Daten aus anderen Bereichen zu erwerben

- und ihre eigenen Analysen effektiv durchführen.

4. Gemeinsame Verwaltung

Obwohl die Datenverwaltung und das Datenmanagement in den einzelnen Bereichen auf die Domänen-Teams verteilt sind, gibt es ein übergreifendes föderiertes Governance-Team, das eine überwachende und koordinierende Rolle spielt.

Es besteht in der Regel aus Vertretern aller beteiligten Teams, einschließlich der IT-Abteilung. Gemeinsam einigen sie sich auf Standards und gemeinsame Richtlinien für Interoperabilität, Dokumentation, Sicherheit, Datenschutz und Compliance. Diese Richtlinien bilden die Regeln für den Betrieb im Data Mesh, insbesondere für die Art und Weise, wie die Domänen-Teams ihre Datenprodukte erstellen sollten.

In vielen Anwendungsfällen ist das föderierte Governance-Team auch für all jene Datenelemente verantwortlich, die über Domänen hinweg gemeinsam genutzt werden. Wenn einige Daten in mehreren Domänen doppelt vorhanden sind, werden sie oft unter die Verwaltung des föderierten Governance-Teams gestellt. Auf diese Weise werden Duplikate aus den domänenspezifischen Datensätzen entfernt.

Data Mesh konzentriert sich in erster Linie auf die Verwendung von Daten für analytische und nicht für operative Zwecke. Daher werden Datenprodukte, die zur Erfüllung von Echtzeitanforderungen verwendet werden, nicht berücksichtigt.

Data Mesh ist eine ideale Lösung für Organisationen, in denen die IT-Systemumgebung nach den Prinzipien des domain-driven Designs oder ähnlichem modularisiert ist. Das bedeutet nicht, dass es nicht auch von Unternehmen eingesetzt werden kann, die mit Datensilos arbeiten, wie zum Beispiel Data Warehouses oder Data Lakes. Es ist nach wie vor möglich, sofern die relevanten Bereiche der Datendomänen getrennt sind und innerhalb dieser Silos von speziellen Teams verwaltet werden.

Die Voraussetzung für Data Mesh ist eine ausreichende Anzahl unabhängiger Domänen-Teams, die ihre Systeme bereits in Produktion haben. Wenn Ihre Organisation jedoch zu klein ist und Sie nicht über viele unabhängige Teams verfügen, sollten Sie diesen Ansatz eher vermeiden.

Wie Data Fabric ist auch Data Mesh kein fertiges Produkt oder eine fertige Technologie. Es gibt kein allgemeingültiges Modell für die Architektur. Es gibt nur allgemeine Annahmen und Richtlinien, die das gesamte Konzept definieren. Daher kann jedes Unternehmen es so gestalten, dass es am besten zu den eigenen Besonderheiten und Bedürfnissen passt.

Wichtig ist, dass beide Ansätze – Data Fabric und Data Mesh – mit denselben Tools implementiert werden können. Der Unterschied liegt in der Modellierung der gesamten Architektur, der unterschiedlichen Organisation der Teams und der Implementierung verschiedener Prozesse innerhalb des Unternehmens.

Digitaler Zwilling des Kunden

Das Konzept des digitalen Zwillings ist bekannt und wird seit Jahren erfolgreich in der industriellen Fertigung eingesetzt. Mithilfe von Internet of Things (IoT) und Machine Learning werden virtuelle Nachbildungen von realen Objekten – Maschinen, Geräten, Produktionslinien usw. – erstellt. Es wird auch zunehmend zur Überwachung und Modellierung von Prozessen eingesetzt.

In den letzten Jahren hat dieses Konzept auch in vielen anderen Branchen Anwendung gefunden, beispielsweise im Bauwesen, in der Logistik, im Automobilbau, in der Medizin, im Gesundheitswesen, in der Luftfahrt, in der öffentlichen Verwaltung und sogar in der Tiermedizin. Auch im Handel gewinnt es immer mehr an Bedeutung, da es verspricht, ein digitales Modell des Kunden mit seinen Vorlieben, Emotionen und seinem Kaufverhalten zu erstellen.

Auf den ersten Blick ähnelt dieses Konzept dem Customer 360 View, der mit einer Customer Data Platform (CDP) erstellt werden kann. In der Tat ist der Ausgangspunkt für die Erstellung eines digitalen Zwillings die Sammlung umfassender Kundendaten aus allen verfügbaren Quellen. Der Digital Twin geht jedoch viel weiter und bedient sich künstlicher Intelligenz und Machine Learning, um Kundenerfahrungen zu simulieren und diese Simulationen in Echtzeit anzupassen.

Der Schlüssel zur Erstellung eines solchen selbstlernenden Modells sind Verhaltensdaten aus der Customer-Journey-Analyse. Zu diesem Zweck werden alle Kundeninteraktionen mit einer Marke überwacht, sowohl in digitalen als auch in Offline-Kanälen. Es können auch andere Daten verwendet werden, wie beispielsweise die Geolokalisierung.

Natürlich kann man einer Person keine Sensoren anbringen und sie nicht 24 Stunden am Tag verfolgen. Deshalb ist es wichtig, so viele Touchpoints zwischen Kunde und Marke wie möglich über alle Kanäle hinweg zu schaffen. Hierzu müssen Sie sicherstellen, dass Sie alle Interaktionen digital erfassen und daraus nützliche Daten gewinnen können.

Um so viele Daten wie möglich zu erhalten, brauchen Sie ein Konzept, wie Sie Kunden dazu bringen können, an diesen Touchpoints zu interagieren und somit Informationen mit Ihnen zu teilen.

Außerdem muss alles mit dem vollen Bewusstsein und der Zustimmung der Kunden geschehen. Hierfür sind eine angemessene Datenschutzpolitik und ein Einwilligungsmanagement erforderlich.

Um die Genauigkeit des Modells zu gewährleisten, reicht es nicht aus, eine ausreichend große Menge an Daten zu sammeln. Ihre Qualität ist ebenso wichtig. Doppelte, unvollständige, falsche oder veraltete Daten können das Bild des Kunden verzerren und ein falsches Modell erstellen, das nutzlos oder sogar schädlich für Ihr Unternehmen ist. Daher ist ein umfassendes Datenqualitätsmanagementsystem ein Muss, wenn Sie über einen digitalen Zwilling nachdenken.

Für die nötige Datenqualität müssen Sie die Kundenidentität präzise feststellen können. Dazu gehört die Fähigkeit, aufgezeichnete Interaktionen bestimmten Personen korrekt zuzuordnen. Dies kann eine große Herausforderung darstellen, da der Kunde für verschiedene Interaktionen mit Ihrer Marke unterschiedliche Authentifizierungsmethoden verwenden kann, z. B. verschiedene E-Mails, Telefonnummern oder sogar Postadressen. Um dieses Problem zu bewältigen, benötigen Sie zuverlässige Funktionen zur Identitätserkennung.

„Die Vorlieben und Verhaltensweisen der Kunden ändern sich schnell und häufig, so dass sich der digitale Zwilling mit ihnen weiterentwickeln muss“, erklärt Krzysztof Wiśniewski. „Dies erfordert eine ständige Versorgung mit neuen Daten und eine entsprechende Anpassung des Machine-Learning-Modells. Es handelt sich um einen geschlossenen Kreislauf – neue Daten verbessern und justieren das Modell, während dieses sich entwickelnde Modell zur Gestaltung künftiger Interaktionen verwendet wird, die neue Daten liefern.“

Unter den vielen Vorteilen, die die Einführung des digitalen Zwillings eines Kunden mit sich bringt, sind die wichtigsten folgende:

- besseres Verständnis der Kundenmotivation – warum sie sich engagieren und bei Ihnen kaufen

- Nachahmung und Vorhersage des Kundenverhaltens

- Modifizierung und Bereicherung der Kundenerfahrung

- bessere Personalisierung

- genauere Empfehlungen

- Gestaltung optimaler Einkaufserlebnisse

- Testen von Marketingkampagnen

- Auswahl der besten Kaufanreize

- Testen neuer Produkte und Dienstleistungen.

Das Konzept des digitalen Zwillings des Kunden birgt sehr viel Potenzial. Es wird sich nach und nach entsprechend den Fortschritten bei der künstlichen Intelligenz und den Machine-Learning-Technologien weiterentwickeln.

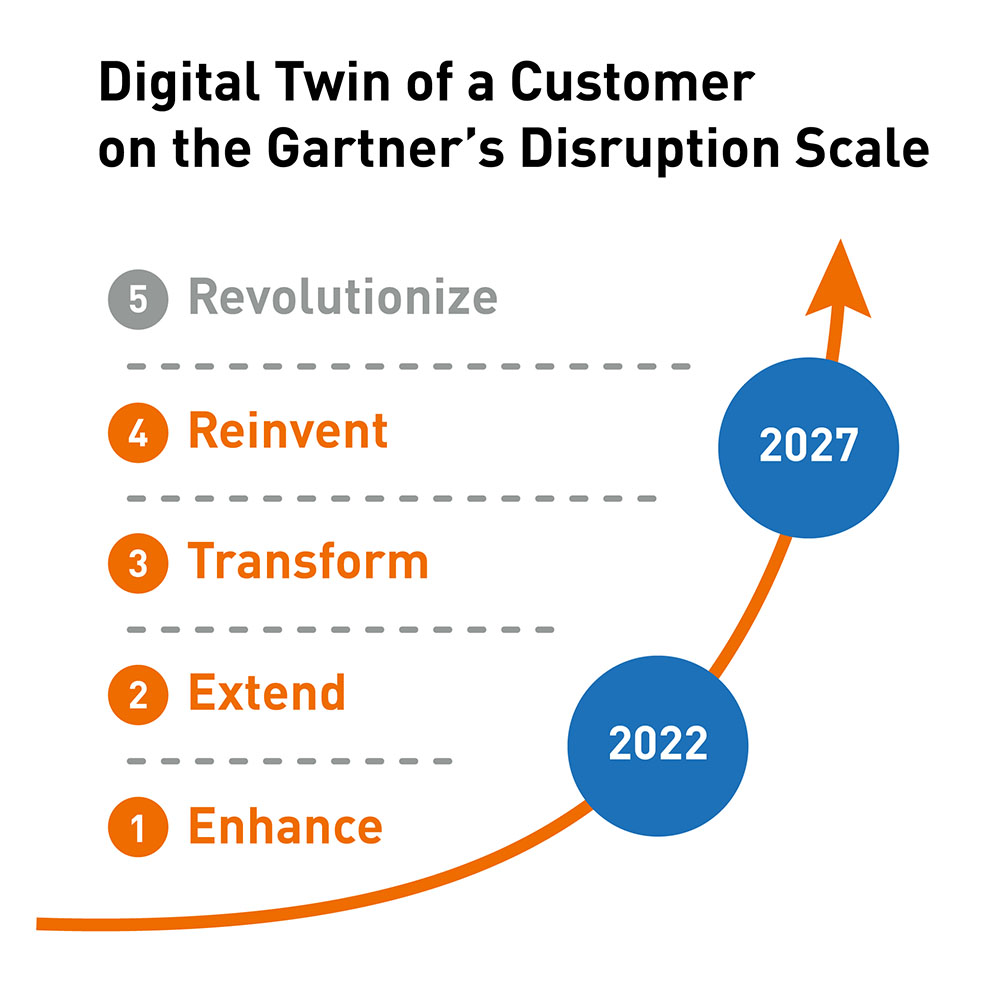

In welche Richtung bewegt sich dieses Konzept? Die Digital Disruption Scale von Gartner liefert die Antwort.

Auf einer fünfstufigen Skala ordnet Gartner den digitalen Zwilling des Kunden für das Jahr 2022 fast am Anfang seiner Reise ein, irgendwo zwischen der Verbesserung (Stufe 1) und der Erweiterung der Märkte (Stufe 2). Es wird noch fünf Jahre dauern, bis er Stufe 4 erreicht und zur treibenden Kraft bei der Neuerfindung der Märkte wird.

Gartner prognostiziert außerdem, dass der Markt für Software und Dienstleistungen, die digitale Zwillinge ermöglichen, bis 2030 weltweit 150 Milliarden Dollar erreichen wird, gegenüber 9 Milliarden Dollar im Jahr 2022.

AR- und VR-Daten

Dank der rasanten Entwicklung von Digital-Reality-Technologien sind wir in der Lage, nahezu jeden Bereich unseres privaten oder beruflichen Lebens mit Daten oder Metadaten digital zu bereichern. Auf diese Weise können Unternehmen die Fülle an Informationen nutzen, um ihren Kunden eine ganz neue Erlebnisdimension zu bieten. Aber das ist nicht der einzige Nutzen dieser Technologie.

Derzeit gibt es drei führende Arten von digitalen Realitäten:

- Augmented Reality (AR) – hierbei werden digital erzeugte 3D-Bilder, akustische Elemente oder andere sensorische Informationen in die reale Welt eingeblendet. Für die Nutzung ist in der Regel ein mobiles Gerät erforderlich, so dass die Möglichkeit, mit der digitalen Dimension zu interagieren, (zumindest im Moment) auf den Bildschirm eines Smartphones oder Tablets beschränkt ist.

- Virtual Reality (VR) – schafft eine komplett digitale und vollständig interaktive 3D-Umgebung, in die der Nutzer eintaucht und von der realen Welt isoliert ist. Am häufigsten werden VR-Headsets benötigt, die Brillen mit eingebauten Kopfhörern und Mikrofonen enthalten. Neben der Schaffung fiktiver Welten kann VR auch zur Entwicklung digitaler Kopien realer Orte verwendet werden. So können die Nutzer beispielsweise ein Museum besuchen, durch ein Geschäft, ein Lager oder eine Produktionsstätte gehen, als wären sie tatsächlich dort.

- Mixed Reality (MR) – verwendet holografische Linsen (z. B. in intelligenten Brillen), um VR- und AR-Elemente mit der realen Welt zu kombinieren, so dass digitale Objekte mit realen Objekten interagieren können.

Da für AR keine spezielle Ausrüstung erforderlich ist, hat sie sich schnell zur beliebtesten und am weitesten verbreiteten der drei oben genannten Technologien entwickelt. Man kann mit Sicherheit sagen, dass sie von buchstäblich jedem genutzt werden kann.

Die Popularität dieser Technologie wird auch durch die zunehmende Auswahl und Erschwinglichkeit von Software-Tools für ihre Implementierung gefördert. Die Unternehmen müssen also nicht mehr viel Geld in eigene Lösungen investieren, um die vorhandenen Daten schnell nutzen zu können.

Am weitesten verbreitet ist AR im Einzelhandel, wo es das Kundenerlebnis sowohl in als auch außerhalb von Geschäften verbessert. So können Kunden beispielsweise Produkte vor dem Kauf in ihren eigenen vier Wänden betrachten – um Kleidung virtuell anzuprobieren, zu sehen, ob neue Möbel in einen Raum passen, oder um die richtige Farbe für einen Wandanstrich auszuwählen.

Diese Technologie findet auch in vielen anderen Branchen und Lebensbereichen Anwendung, wie im Marketing, in der Fertigung, im Gesundheitswesen, in der Automobilindustrie, in der Produktentwicklung, im Tourismus und im Bildungswesen.

Die Nutzung vorhandener Daten zur Verbesserung der Realität ist die eine Sache. Eine andere ist das breite Spektrum an Daten, die aus der menschlichen Interaktion mit der erweiterten und virtuellen Realität gewonnen werden können. Aus der Art und Weise, wie ein Nutzer mit der digitalen Welt interagiert, lassen sich viele wertvolle Informationen über seine Vorlieben (z. B. bei der Produktauswahl), sein Verhalten (z. B. beim Besuch eines virtuellen Geschäfts), seine Fähigkeiten (z. B. beim virtuellen Training), über die Nutzung von Produkten oder Geräten usw. zu erhalten.

Richtig verarbeitet und genutzt, ermöglichen diese Daten den Unternehmen, ihren Vertrieb, die Kundenbetreuung, die Raumgestaltung in den Geschäften, die Entwicklung von Produkten und Dienstleistungen, die Gestaltung von Prozessen, die Schulung von Mitarbeitern etc. zu verändern.

Man kann ohne Übertreibung sagen, dass die digitalen Realitäten ihre besten Zeiten noch vor sich haben. Der Durchbruch könnte in der Verbesserung und Verbreitung der holografischen Technologie liegen, zum Beispiel in der Möglichkeit, gewöhnliche Brillen in AR/VR-Brillen zu verwandeln. Oder die Fähigkeit, holografische Bilder im Raum anzuzeigen und frei mit ihnen zu interagieren, was aus Science-Fiction-Filmen bekannt, aber heute gar nicht mehr so unrealistisch ist.

Verarbeitung unstrukturierter Daten

Die meisten der heutzutage erzeugten Informationen sind unstrukturierte Daten. Verschiedenen Studien zufolge machen sie bis zu 80-90 % aller Daten aus. Darüber hinaus sind unstrukturierte Daten die am schnellsten wachsende Datenkategorie.

Am häufigsten handelt es sich bei unstrukturierten Daten um Text, aber es gibt sie auch in Form von Bildern, Audio- und Videodateien. Beispiele für solche Daten sind:

- vollständige Texte von E-Mails

- Kundenrezensionen, Kommentare und Meinungen

- Beiträge, Bilder und Videos aus Blogs und sozialen Medien

- Gesprächsprotokolle

- Unterhaltungen aus Diskussionsforen

- Online-Chats

- Anrufe des Kundendienstes

- Protokolle von Websites, Servern, Netzwerken und Anwendungen

- Daten von Sensoren auf IoT-verbundenen Geräten.

Im Gegensatz zu strukturierten Daten verfügen unstrukturierte Daten nicht über ein vordefiniertes Datenmodell oder Schema. Daher können sie nicht einfach in einer herkömmlichen relationalen Datenbank, Tabelle oder Tabellenkalkulation gespeichert werden, die auf einer Spalten-Zeilen-Struktur der Informationen basiert. Sie sind auch nicht leicht zu klassifizieren. Es ist zum Beispiel nicht möglich, eindeutig zu bestimmen, ob es sich bei einem Datenelement um eine ganze Zahl, ein Datum, eine Uhrzeit oder einen anderen Typ handelt.

All dies macht unstrukturierte Daten zur größten Herausforderung im Umgang mit Daten – von der Erfassung und Speicherung bis hin zur Verarbeitung, Suche und Analyse.

Noch vor einiger Zeit waren unstrukturierte Daten für Unternehmen nahezu nutzlos. Der Hauptgrund dafür war das Fehlen geeigneter Technologien und Software, um solche Informationen effektiv zu verarbeiten und zu analysieren.

Heute stehen den Unternehmen jedoch zahlreiche Tools zur Verfügung, die die Verarbeitung natürlicher Sprache, die Umwandlung von Sprache in Text, die Bilderkennung, die Analyse von Gefühlen, die Mustererkennung und andere auf KI und Machine-Learning basierende Technologien unterstützen. Sie ermöglichen es ihnen, Informationen aus riesigen Mengen unstrukturierter Daten zu identifizieren und zu extrahieren, sie zu analysieren und daraus wertvolle Erkenntnisse zu gewinnen.

In der Praxis können unstrukturierte Daten eine Fülle unschätzbarer Informationen enthalten, einschließlich strukturierter Daten, die mit anderen Inhalten vermischt sind. Die Mitschrift eines Telefongesprächs mit einem Kunden kann zum Beispiel dessen persönliche Daten, Erwartungen bezüglich Preis und Verkaufsbedingungen oder sogar Informationen über seine Einkäufe bei Ihren Konkurrenten enthalten.

In vielen Fällen sind unstrukturierte Daten das fehlende Puzzlestück, um das Ganze zusammenzufügen und einen vollständigen Einblick in bestimmte Themen zu erhalten.

„Ohne unstrukturierte Daten ist es für Unternehmen zum Beispiel schwierig, ein vollständiges Bild eines Kunden zu erhalten“, so Krzysztof Wiśniewski. „Sie kennen vielleicht alle persönlichen Daten eines Nutzers, seine Kaufhistorie, die aufgerufenen Produkte und Inhalte, aber daraus lassen sich keine zuverlässigen Erkenntnisse über die Einstellung des Kunden zu Ihrer Marke ableiten. Die Informationen, die Sie benötigen, sind in von Kunden generierten Inhalten verschlüsselt, vor allem in sozialen Medien und Diskussionsforen.“

Einfach ausgedrückt: Ohne unstrukturierte Daten, die mit KI/ML analysiert werden, haben Sie keine Chance, eine wirklich vollständige Sicht auf den Kunden (Customer 360) zu erstellen, geschweige denn einen digitalen Zwilling des Kunden.

Das Gleiche gilt für Ihre Produkte und Dienstleistungen. Das Sammeln und Analysieren dessen, was Kunden über Ihre Angebote sagen – ihre Kommentare, Bewertungen, Fotos oder Videos – ermöglicht es Ihnen, die Stärken und Schwächen Ihres Angebots besser zu verstehen und infolgedessen präzisere Entscheidungen über zukünftige Entwicklungen zu treffen.

Der enorme Geschäftswert unstrukturierter Daten kann in allen Branchen und in unzähligen Anwendungsfällen aufgedeckt werden, zum Beispiel:

- Betrugserkennung in der Finanz- und Versicherungsbranche

- Krankheitsdiagnose und Festlegung von Behandlungsmethoden im Gesundheitswesen

- Erkennung von Trends, z. B. Kaufverhalten von Kunden

- frühzeitige Erkennung von Fehlfunktionen in Anlagen, z. B. Motoren, Produktionsmaschinen, Elektrowerkzeugen

- Ermittlung der Bereitschaft eines Kunden, ein bestimmtes Produkt zu kaufen

- Verbesserung von Call-Center-Diensten durch semantische Analyse von Kundengesprächen.

Das Potenzial unstrukturierter Daten liegt nicht nur in der riesigen Menge an Informationen, die extrahiert werden können, sondern auch in der Tatsache, dass noch immer nur wenige Unternehmen in diesem Bereich tätig sind.

Eine Umfrage von Deloitte ergab, dass die meisten Unternehmen (64 %) auf strukturierte Daten aus internen Quellen zurückgreifen, während nur 18 % unstrukturierte Daten nutzen. Eine andere Studie zeigte, dass derzeit nur 0,5 % der unstrukturierten Daten analysiert werden.

Was bedeutet das für Ihr Unternehmen? Wenn Sie sich jetzt mit dem Thema befassen, können Sie schnell einen erheblichen Vorteil gegenüber Ihren Mitbewerbern erlangen.

Das könnte Sie auch interessieren:

BLOG

B2B E-Commerce – Freund oder Feind des Vertriebs?

Viele traditionellen Vertriebler in B2B-Unternehmen haben Vorbehalte gegenüber E-Commerce, weil sie den digitalen Verkaufskanal als Konkurrenz empfinden. Dabei kann es ihr nützlichstes Tool sein.

die maßgeblich für die Auswahl der besten Lösungen für Ihre E-Commerce-Plattform sind.

LEITFÄDEN

Auswahl von E-Commerce-Lösungen

Laden Sie unsere beiden kostenlosen Leitfäden herunter – Sie erhalten eine ausführliche Analyse der Schlüsselfaktoren,

E-BOOK

B2B Commerce – Mehr als nur ein Onlineshop

Um die Erwartungen der Geschäftskunden zu erfüllen, müssen B2B-Plattformen eine Vielzahl von Funktionen und Möglichkeiten bieten, die in B2C-Onlineshops nicht zu finden sind.